NetApp EF540 Flash Array

Несмотря на то, что я уже не раз в этом блоге обещал не слишком писать про NetApp E-series (по разным причинам, не буду вдаваться в детали, уже писал неоднократно почему), но как-то так, в насмешку над моими словами, жизнь заставляет писать о них почаще. А сегодня есть повод еще раз поднять тему E-Series, потому что в ней появился интересный продукт – Flash Array.

??з названия нетрудно догадаться, что это становящийся сегодня все более популярным так называемый all-flash массив, то есть сторадж сделанный только на flash SSD, без классических, “вращающихся” дисков вовсе. На рынке уже несколько лет как присутствуют такие устройства, прежде всего это системы хранения производства компании Violin Memory, пионера подобных систем, и Texas Memory Systems (ныне принадлежащая IBM).

Если вы читаете этот блог достаточно давно, то вы уже знаете, что в линейке NetApp есть самые разнообразные продукты с использованием Flash, можно даже сказать, что NetApp имеет вообще все возможные варианты, и в этом по своему уникальна. Считайте сами: FlashCache, встроенный в систему хранения кэш на flash memory, Flash Pool, гибридный дисково-flash-евый массив, прозрачный для пользователя и его задач, FlashAccel – софтверное решение, позволяющее использовать диски SSD на стороне сервера интегрировано, в общей инфраструктуре хранения, и вот, наконец, четвертый возможный вариант использования flash, all-flash array, “дисковый” массив состоящий из чистых SSD.

Как показывает нам его название, он построен на базе весьма удачных массивов “классической” архитектуры, досташихся NetApp вместе с приобретенным несколько лет назад подразделением компании LSI под названием Engenio, производящей крайне удачные блочные массивы по OEM-контрактам, вы их, уверен, хорошо знаете как дисковые массивы IBM DS, а также ряд других систем хранения от других компаний. Это все – Engenio, ныне подразделение NetApp.

Под крышей NetApp Engenio получила “второе дыхание” и дисковые массивы “традиционной” блочной архитектуры используются NetApp для ряда специальных проектов, например для grid-систем под Hadoop, или для систем video surveilance, а также поставляются всем прежним OEM-клиентам Engenio.

Вот на базе дисковой полки и контролллеров 5400-серии и был сделан EF540 Flash Array.

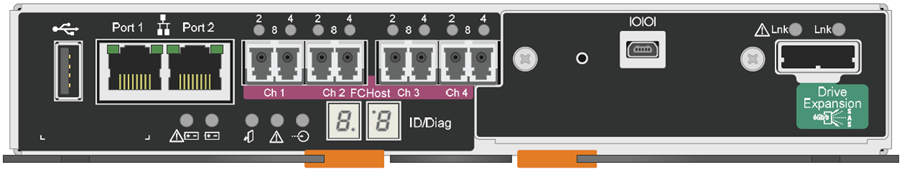

Вид контроллеров сзади:

Система поставляется в двух вариантах: с 12 и с 24 дисками MLC SSD на 800GB raw (то есть с суммарной емкостью 9,6 и 19,2 TB raw) и обеспечивает в максимуме около 300 тысяч установившихся IOPS чтения (100% random read, 4K) при менее 1 ms latency (или же около 6GB/s throughput большими блоками, то есть, конечно, не одновременно с 300K IOPS).

На контроллерах в стандартном форм-факторе SBB v2.0, слева направо:

Порт USB для диагностики и обслуживания. Два порта Ethernet для управления (это НЕ для передачи данных! Только для админнистрирования! Ни iSCSI в базе, ни NAS тут нет!), далее 4 независимых порта 8Gb/s FC. Правее находится схемный модуль, так называемый Host Interface card, в котором располагается, на рисунке, последовательная консоль и порт SAS 6Gb/s drive expansion, который в EF540 НЕ ??СПОЛЬЗУЕТСЯ, подключить к EF540 дополнительные полки НЕЛЬЗЯ.

Кроме показанного на рисунке также возможны иные варианты такого Host interface module, например с еще плюс 4x 8G FC, 4x 6G SAS (не для расширения, а для IO, например для подключения в SAS Switch и доступа по ним от сервера), 2x 10G iSCSI или же 2x 40G Infiniband (в последнем случае штатные порты FC отключены). На контроллере также располагается 12GB кэш-памяти. Поддерживаются типы RAID – 0,1,5,6,10.

Нацелены данные системы, прежде всего, как и все E-series в линейке NetApp, на определенную узкую “нишу” крайне высокопроизводительных приложений, это, прежде всего, энтерпрайзные базы данных, где latency играет решающую роль, и за что, следует специально подчеркнуть, компании готовы платить, и платить много. Это НЕ системы “для всех”, это нишевое решение для тех, у кого предельно низкие значения IO latency это решающий фактор.

Ну и, конечно же, как правило, EF540 будет использоваться не столько сама по себе, сколько как компонент более высокоуровневого решения, включающего в себя не только стораджи E-series, но и те же FAS, например уже готов TR, посвященный построению высокопроизводительной базы данных на Sybase ASE, с использованием FAS6200 для хранения данных, и EF540 для ускорения определенных операций, работающих вместе.

??, “чтобы два раза не вставать”, по некоторым слухам, NetApp в России намеревается в ближайшее время начать продавать стораджи семейства E5400 по своему обычному каналу, через партнеров, ранее, напомню, эти системы хранения можно было купить только как OEM-продукт, например через IBM, как DS35xx, сам NetApp, от своего имени, в России их не продавал.