Есть такая известная книжка Unix Hater’s Handbook. Решил и я завести себе такое, “ненависти к NetApp псто”, дабы не быть попрекомым безоговорочными “соплями в сахаре” по поводу Нетаппа, и собрать по максимуму все то, что “мешает нам жить” у в остальном любимого вендора и его продукта.

Начнем, пожалуй, с веб-интерфейса FilerView. Постепенно и уже с трудом выносимо устаревающий WebGUI FilerView, бывший безусловным прорывом… году этак в 2003-м. Но с тех пор, кажется, не изменялся вообще. В особенности силен контраст с тем, что получили сейчас конкуренты, взять тот же Sun OpenStorage.

Да, я знаю, что “настоящие админы используют только командную строку”, знаю и про System Manager. Но почему это должно убивать простой и понятный, доступный удаленно и под любой платформой с браузером веб-интерфейс, тем более, уверен, написать новый, красивый, современный, со всеми новыми удобными фишечками и вообще eye-candy веб-интерфейс это задача для пары фрилансеров на месяц работы?

Долгожданная “восьмерка” так и не принесла столь же долгожданной интеграции ONTAP ???G7’ и ONTAP GX. В результате мы имеем фактически всего лишь два продукта (отдельно – cluster-mode, и отдельно 7-mode) устанавливающихся из одного дистрибутива. С разной функциональностью, несовместимых и не “переключающихся” между режимами.

Конечно я знаю о необходимости поддержки огромного парка старых систем, работающих на прежних версиях, и все прочее. Но, ребята, злосчастный Spinnaker и его наследие “пережевывается” компанией уже около 6 лет! Да, NetApp был одним из первых, кто начал заниматься “облачными хранилищами”, и увидел их перспективы задолго до того, как о них заговорили все. Но он также фактически последним вывел на рынок реальные “массивно-кластерные” системы (а некоторые клиенты так их и не дождались, так, например, MySpace в свое время ушли с NetApp на Isilon именно по этой причине). Многобещающее приобретение компании Spinnaker много лет не давало никакого заметного “выхлопа” в продукте, а вышедший на рынок Data ONTAP GX имел множество ограничений, и массовым, увы, не стал, оставшись весьма нишевым продуктом.

О, о “восьмерке” говорить можно долго. ;-| Если вы планируете переходить на G8 ???7-mode’, продумайте все до мелочей. Зачастую “обратного хода” не будет. Переход на долгожданные “длинные”, 64-bit aggregates это “дорога с односторонним движением”. Существующие “32-bit” аггрегейты никак не превращаются в новые, 64-bit. Да, только забэкапить, остановить, убить старые, вместе со всеми томами и LUN-ами на них, создать новые, пересоздать на них обратно тома и LUN-ы, и восстановить содержимое. Звучит просто для демо-лабы. Но, подозреваю, предложи вы такое энтерпрайз-админу с несколькими mission-critical стораджами, весьма вероятно он вас попытается придушить куском патч-корда.

??, да, “если что-то пошло не так”, вернуться на “семерку” вы не сможете.

??, кстати, да, перейти вы сможете только в случае если вы в свое время купили “подходящее” оборудование. Купили FAS2050 и планируете наращивать его емкость, потому что контроллерной мощности вам хватает? Для вас нет ONTAP 8. ?? не будет. Причем и FAS2050, и FAS2020 по прежнему продаются, и вполне себе recent hardware, по крайней мере с точки зрения продавцов NetApp.

Предмет обоснованной гордости нетапповцев, полная сквозная совместимость продуктовой линейки, простота апгрейда и длительная поддержка в софте даже “старых” систем и данных на них, увы, в прошлом.

Серия FAS2000 вообще выглядит “бедным родственником”, впрочем, по понятным причинам, для вендора, но нам, пользователям, от этого не легче. Мы купили FAS2050, с 20 дисками SAS, а теперь, спустя пару лет, хотим мигрировать на FAS3140 с полкой DS4243 с дисками SAS, можем ли мы использовать уже заполненные данными наши 20 дисков с системы FAS2050, для минимизации затрат на миграцию, да и ведь они тоже SAS, и стоят немало? Не можете. Конструктив дискового “фрейма” несовместим. Можете попробовать продать их на eBay, удачи.

Очень неприятен “заговор молчания” вокруг “проблемы фрагментации WAFL”. Никаких комментариев. Никаких официальных цифр. Кормитесь слухами (ну и, конечно, “радостными” пугалками довольных конкурентов!).

Нам, пользователям NetApp, нужен, наконец, официальный technical report и best-practices на этот счет! Они есть по куда менее значительным и существенным аспектам эксплуатации системы, они должны быть и о путях решения этой проблемы.

Нужно открыто и ясно сказать все, что компания думает об этом, о путях возникновения, избежания, и реальном влиянии fragmentation и reallocate на производительность на конкретных примерах и в открытом тестировании. Это единственный путь свести к минимуму результаты FUD конкурентов на этот счет!

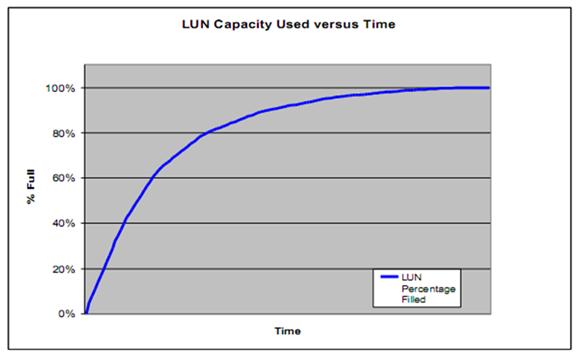

Aggregate из дисков может быть увеличен, но не уменьшен. В него легко добавить диски, но нельзя “извлечь”. Я согласен с тем, что создание aggregate это достаточно ответственный процесс, чтобы к нему подойти осмотрительно и дальновидно, тем более, что, на реальной системе, не слишком часто приходится изменять его размеры произвольно. Но, тем не менее, это очевидная негибкость. Бывает очень неприятно осознавать, что добавленный только что диск в aggregate, на котором уже с десяток томов с данными, был добавлен преждевременно, или предназначался для другого aggregate, более в нем нуждающегося. Ан нет, все.

Совершенно непонятна история с VTL и попыткой покупки Data Domain.

У NetApp существует (теперь уже стоит говорить “существовал”) свой собственный, и, судя по словам попробовавших, довольно неплохой продукт NetApp VTL, полученный вместе с приобретенной ранее компанией Alacritus. Возможно он был неидеален. Наверняка там было куда расти. Но он уже был, работал, развивался и, кстати, неплохо продавался. После довольно долгих мытарств (свыше года разработки) на этой платформе была реализована технология дедупликации, причем была создана иная, нежели на FAS система, с рядом улучшений (например с компенсацией “смещения” содержимого идентичных блоков данных, часто встречающегося в резервных копиях), в перспективе с возможностью имплементации онлайн-дедупликации, вдобавок к уже сделанной “оффлайн”.

Но покупка срывается, Data Domain уходит к EMC.

Вскоре после этого NetApp объявляет о прекращении дальнейших разработок в линейке VTL, и, фактически, отказывается от этой линии в своем продуктовом портфеле.

Допустим, DDUP это отличная технология, превосходящая VTL. Хорошо. Но VTL уже был, продавался, у него были свои клиенты и свой сегмент рынка, недавно были завершены разработки новых, многообещающих софтверных фич. Не удалось купить DDUP – ну что-ж, надо продолжать разрабатывать свою систему, пока она не станет такой же хорошей. Но почему неудача покупки новой технологии должна следом вызывать отказ от другой аналогичной, уже успешно разрабатывающейся в компании, и продающейся несколько лет – я не понимаю, и объяснения нисколько не убедительные.

?? что будет столь же “убедительно” и “мотивированно” будет вдруг похоронено следующим?

“За кефир отдельное спасибо всем” (с) ММЖ

О веб комьюнити, и NOW. Это, как говорится выше, “отдельное спасибо всем”.

Как вы знаете, до недавних пор, до появления сommunities.netapp.com, единственным веб-ресурсом NetApp в интернете был NOW – NeApp On Web. Пусть он уродлив не слишком красив внешне (примерно как FilerView), и его обходит стороной уже третий, если не четвертый, “фейслифтинг” собственно вебсайта NetApp, но на нем можно найти документацию, а также статьи Knowledge Base, и, до открытия communities, примитивный простой, но функциональный форум. Но.

Только если вы имеете в NOW логин. Для полноценного доступа в NOW вам нужен логин, причем логин не просто “посетителя” (который создается “вручную” персоналом и, зачастую, за неделю времени!), с которым вы увидите, фактически, только первую страницу, при переходе с любой на ней ссылке видя сообщение о недостатке прав доступа.

Я правда не понимаю, что такого секретного нельзя показывать посетителям “невладельцам” (например “пока не владельцам”) систем хранения и не сотрудникам компаний-партнеров в текущей документации на Data ONTAP, в статьях Knowledge Base или примитивном форуме пользователей.

Почему, даже не купив ни одного продукта компании Microsoft, пользователь может войти и прочитать и статьи в Knowledge Base, и документацию в TechNet, но ровным счетом ничего (кроме как разлогиниться) не может в NOW?

Что за секреты там хранятся? Я лично не нашел ни одного.

Ах, да. Если вы создали (вам создали) логин в communities и NOW, привязанный к e-mail, а потом, по той или иной причине вы доступ к этому e-mail потеряли (простейший пример – уволились, перейдя в другую компанию), то перенести ваш логин на другой e-mail нельзя. Бросайте свои завоеванные рюшечки, звездочки и пойнты за ответы и помощь коллегам, записи в блоге и собранные букмарки своего привычного и “прокачанного” аккаунта и начинайте снова, с новым логином.

Ну и напоследок.

Компания – живой организм. Люди приходят и люди уходят, это естественная жизнь. Некоторые из сотрудников NetApp ведут на сайте компании свои блоги, и это замечательный источник информации о продуктах компании. За несколько лет такие блоги часто становятся источником очень полезных статей, на многие из них ссылаются извне, используют изложенные факты в дискуссиях, и так далее.

Но скажите мне, какого, извините, черта, полностью немедленно удалять содержимое интереснейшего и популярного блога, если его человек в компании больше не работает?

Кажется еще совсем недавно я переводил для своего блога серию статей технического директора NetApp Костадиса Руссоса об устройстве WAFL, и вот теперь он ушел из NetApp (в компанию Zynga, кто понимает шокирующую крутизну поворота карьеры;), а на месте его блога открыватся пустая белая страница. ?? это совсем не единичный пример.

??дите, мол, можете попробовать в archive.org найти, он нам больше не сотрудник, и написанное им за несколько лет мы грохнули.

UPD: Ах да, забыл совсем. Non-transferrable licenses. Как вы, наверное, знаете, стоимость систем NetApp складывается из стоимости железок, и стоимости лицензий на те или иные софтверные фичи, которые включаются ими, например на доступные пользователю протоколы, FlexClone, SnaopMirror и прочее. Очень часто стоимость лицензий это добрая половина, а иногда и до двух третей цены системы. Однако эти лицензии - “непереносимы”. Вы купили систему за стотыщпицот долларов, спустя пару-тройку лет хотите ее продать, и у вас есть покупатель. Однако вы не можете официально продать с системой лицензии, купленные вами за полновесные, и заплаченные NetApp, кстати, доллары. А без лицензий эта система - бессмысленная неработоспособная железка, к которой можно подключить только консоль. NetApp считает, что покупатель юзанной системы должен прийти к нетапповским сейлам и заново купить на нее все лицензии, повторно. ?? еще раз заплатить. При этом рынок юзаных нетаппов, и, разумеется, “transferrable licenses”, существует, и довольно широк. Но NetApp предпочитает закрывать глаза и делать страусиный вид, что этого не видит.

В завершение поста (впрочем, уверен, своих претензий в коментариях вы можете добавить, буду этим дополнениям только рад) хотел бы отметить, что, разумеется, никто и ничто не идально, нелепо было бы считать, что как компания, так и ее продукция полностью лишена малейших отрицательных свойств или недостатков. Собственно называть их, в том числе “своими именами” правильно и полезно. ?? ничуть не умаляет всех тех достоинств, которых, как вы видите, набралось на три сотни других постов, на протяжении прошедших 3 лет истории этого блога. Продолжим о достоинствах на следующей неделе.