А сегодня я не буду вам рассказывать ничего полезного, сегодня я просто похвастаюсь и отмечу знаменательную дату.

Ровно 3 года назад я начал вести этот блог, и, удивительное дело, веду до сих пор.

За небольшим перерывом в первой половине 2008 года, когда я считал что завязал с IT, и отправился путешествовать с рюкзаком по Юго-Восточной Азии и ??ндии, я пишу тут о системах хранения NetApp, о технологиях и продуктах этой компании, о разных технических штучках-дрючках.

Как я уже писал на страничке about, я с 2007 года не работаю официально ни на NetApp, ни на какую-либо компанию-партнера NetApp, и в выборе тем и мнения абсолютно свободен, хотя, не стану скрывать, поддерживаю отношения разной степени дружественности как с московским NetApp, так и с некоторыми российскими компаниями, занимающимися их продуктами.

“Зачем же все это вот это все тебе, о чем ты тут три года пишешь, по два поста в неделю, неужели не надоело?” – спросит меня придирчивый мой читатель.

Не знаю, насколько это прозвучит убедительно, но мне на самом деле это интересно.

Главная причина, почему именно NetApp (а мне приходилось работать с разными компаниями и разными системами хранения) в том, что я убежден, и за три года этого блога, не считая 7 лет работы с системами NetApp вообще, я ни разу не разочаровался, что выбрал “играть” именно с этой командой.

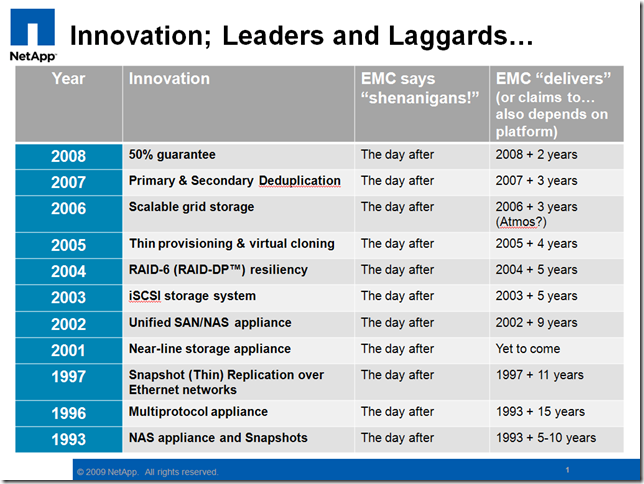

Я на самом деле считаю, что на сегодняшний день NetApp это самая перспективная и высокотехнологичная компания на всем рынке систем хранения данных. Это компания, которая все эти годы постоянно придумывала что-то новое, а не просто торговала терабайтами в ящиках. Это по-настоящему “технологическая” и “инженерная” компания, мыслящая в первую очередь “инженерно”, а не маркетингово, и не “ебитдово”, что чрезвычайно импонирует мне, как человку прежде всего “инженерного” склада.

Разумеется, в индустрии систем хранения существуют многочисленые молодые “стартапы”, которые еще более “инженерные”, но я не знаю другой такой компании, которая проработала 17 лет, вошла бы в тройку крупнейших производителей мире, и при этом не “зажирела”, осталась бы способной не просто клишировать придуманное n-лет назад, наращивая цифры “прибыли до выплаты отчислений” и бонусов отделу продаж и топ-менеджменту, торгуя чужими железками по OEM-соглашениям, а на самом деле придумывала бы что-то “не как у всех”, что-то по-настоящему новое, умея на самом деле, а не на словах “Not just ???Think’, but Think Different”.

В конце 2007 года, после трудных раздумий, как я сейчас понимаю “сняв на максимуме”, я оставил работу ведущим инженером в крупной московской компании-партнере NetApp, и отправился “заниматься собой”, в долгое путешествие по Азии, без планов возвращаться. Но “бывших айтишников не бывает”. :)

“Дауншифтинга” не получилось, скорее это “сайдшифтинг”. Я живу в Таиланде, в городе Чианг Май, занимаюсь “удаленным консалтингом”, переводами, и периодически разъезжаю по местностям и странам вокруг, которых, чем больше я узнаю, тем больше понимаю, что “на мой век – хватит”. О “неработе” я пишу в отдельном блоге в Живом Журнале (http://romx.livejournal.com).

Нынешняя мобильность жизни и повсеместность средств связи и протянутости интернета позволяет в работе практически не задумываться о “географическом местоположении” работника, осталось чтобы эта мысль наконец нашла массового работодателя. ;)

PS. ?? да, кстати, пользуясь случаем, по личному опыту могу уверить вас, что в классическом фотобанковском “визуальном клише” удленного работника в виде человека сидящего с ноутом в шезлонге на пляже у моря нет ни грана правды. Во-первых на солнце на экране ничего не видно. Во-вторых песок сыплется в клавиатуру. В общем я пробовал: “Everybody lies” ;)