Ранее я уже писал о том, что такое Multi-Path High Availability (MPHA) – методе подключения дисковых полок к контроллеру, сделав перевод официального FAQ. Однако обещал, что чуть позже напишу еще некоторые мои соображения на этот счет. Вот они.

Кратко, для “введения в суть”: MPHA это, на сегодня, настоятельно рекомендованный способ избыточного и отказоустойчивого подключения дисковых полок к контроллерам на системе хранения NetApp. Суть его состоит в том, что каждый “стек” полок подключается не просто парой избыточных кабелей в два порта каждого стека полок, но четырьмя кабелями, одной парой с одного конца стека, а второй – с противоположного конца, задействуя не два, а четыре инициатор-порта на каждом из кластерной пары контроллеров (поясняющие схемы можно посмотреть в статье по ссылке выше). ??того, на два контроллера, работающих с двумя стеками полок, получается восемь портов и восемь путей к дискам (с одним стеком, соответственно, четыре).

Такая схема обладает большей надежностью, так как позволяет решить проблему со сбоем или обрывом соединения в дисковой полке посередине большого стека, проблем в интерфейсном модуле полки, или межполочном соединении, или же отказу пути, который приводит к необходимости кластерного файловера и перебросу данного дискового стека на контроллер-партнер. Кроме того, так как оба пути, и в “голову”, и в “хвост” стека, активны, это может, потенциально, повысить пропускную способность канала от контроллера к дискам, если система “забила” потоком данных один из этих путей.

Проблема тут возникает для систем “малого класса”, а именно для FAS2040, у которой всего два порта SAS на систему (один на контроллер), и FAS3210, которая, как вы помните, имеет два порта SAS в контроллере и всего два слота расширения (и нет возможности поставить блок расширения портов IOXM, который есть только для 3240/3270).

FAS2040 совсем не может использовать “классический” рекомендованный вариант MPHA, а FAS3210 может его использовать только в варианте с дополнительной платой интерфейсов SAS, которая занимает один из двух слотов расширения.

(исправлено 30.09 romx, Теперь эта проблема в конфигураторе с неотключаемым для 3200 MPHA изменена)

Таким образом у покупателя FAS3210, например, есть выбор поставить в оставшийся слот плату Flash Cache ??Л??, например, 10Gb Ethernet, но НЕ одновременно.

Проблема заключается в том, что, если ранее, MPHA в конфигураторе была отключаемой опцией, и можно было снять эту галку в чекбоксе, и при этом освобождался искомый слот, то теперь, увы, MPHA это обязательная опция конфигурирования, и, следовательно, в один слот из двух у 3210 в обязательном порядке будет поставлена карта SAS-портов, оставляя доступной пользователю и его выбору только один слот.

??менно этим объясняется отказ пресейла партнера NetApp отключить MPHA и сделать вам, допустим, FAS3210 с Flash Cache и 10Gb Ethernet одновеменно. Ему просто не дает это сделать конфигуратор.

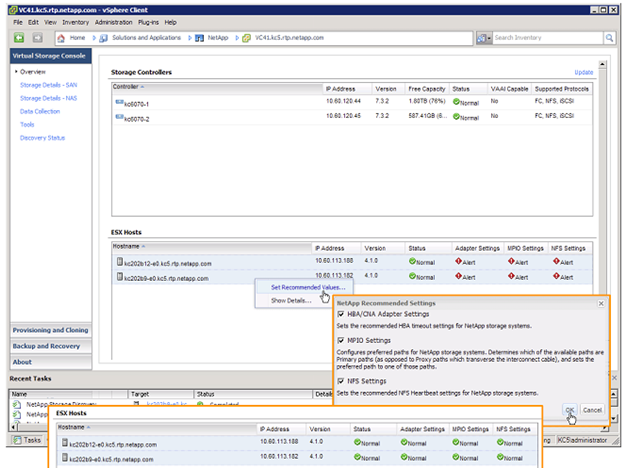

Однако вариант подключения без MPHA, хотя MPHA и настоятельно рекомендуемый, навязываемый конфигуратором и “обязательный”, как о нем пишет переведенный ранее FAQ, все же работает, поддерживается NetApp, и, более того, именно такой вариант сконфигурирован, например, в конфигурации FlexPod (что можно посмотреть в опубликованной спецификации на FlexPod), где используется как раз 3210, как раз с Flash Cache ?? двухпортовой 10Gb Ethernet Unified Target card в одном контроллере (и без MPHA полок, соответственно).

То есть, безусловно, MPHA это хорошо, это правильно, но отказ от всех других вариантов подключения это, как я понимаю ситуацию, политическое, а не техническое решение (по крайней мере на сегодняшний день).

Несколько A на различные Frequently Q:

Q: Означает ли, что отказавшись от MPHA мы получим не-multipath или не-high available подключение полок, а, следовательно, “единую точку отказа” и прочие корпоративные IT-ужасы?

A: Нет, не означает. Не-MPHA подключение также и отказоустойчивое и многопутевое, просто в некоторых специальных случаях сбоев для продолжения доступа к данным при подключении не-MPHA может потребоваться cluster failover, а MPHA сможет работать по дополнительному оставшемуся пути, не проводя cluster failover, и, тем самым, экономя время и не обрывая CIFS-сессии, например. Для небольших систем хранения, например на всего одну-четыре полки на систему, случаи такого вида сравнительно малораспространены. Стоит ли жертвовать ради потенциального устранения этих редких случаев одним слотом из двух на 3210 – решать вам.

Q: Обязательно ли использование MPHA?

A: NetApp считает что обязательно (см. FAQ) для тех систем, где MPHA может быть реализован (исключение, таким образом, только для 2040). Но варианты без MPHA по прежнему поддерживаются. Решение, как я понимаю, за пользователем.

Q: Как же нам все же получить FAS3210 с Flash Cache и 10G Ethernet?

A: Проблема с конфигуратором существовала, но сейчас ее нет. Сейчас в штатном режиме можно получить от партнера спецификацию 3210 с двумя любыми картами внутри, без MPHA. (исправлено 30.09 romx.)

Попросите сконфигурировать вам FAS3210 с Flash Cache и закажите в том же заказе дополнительно плату 10G Ethernet, которая придет отдельно, не установленная в контроллер. Далее вы сможете самостоятельно вынуть карту портов SAS и поставить на ее место карту 10G Ethernet, далее подключите дисковые полки в обычной, не-MPHA, в “традиционной” отказоустойчивой, двухпутевой конфигурации.

Q: Не даете ли вы в данном случае дурного совета?

A: Даю :) Помните, что вы читаете не официальный блог NetApp, а просто заведомо ложные, порочашие измышления на тему, данный пост написан не сотрудником NetApp, и NetApp не несет ответственности за что либо публикуемое в данном блоге. Вышеприведенный совет не является официальной рекомендацией NetApp. Хотя подключение не-MPHA в настоящее время по прежнему поддерживается в существующих системах хранения, и отказ он MPHA на системе хранения не является причиной отказа в поддержке.

Q: Но, все-таки…

A: См. спецификацию FlexPod, валидированную Cisco и NetApp, с использованием FAS3210 без MPHA, в как раз описываемой конфигурации с Flash Cache и 10G Ethernet.