NetApp E5500 - новый сторадж для HPC и Bandwidth-related задач

На этой неделе NetApp продолжил расширять свою E-линейку, пока еще не слишком известную на российском рынке (впрочем, наверняка вы некоторые продукты оттуда знаете как OEM, например IBM DS, Dell MDS, некоторые другие, менее известные вендоры, такие как SGI и даже Oracle, также продают системы NetApp E-series под своими марками).

Буквально недавно я уже писал про EF540, а вот уже выпущена и E5500, дисковая система классической архитектуры, ориентированная на HPC (High-Performance Computing), и на задачи extra-high bandwidth. Это, обычно, высокопроизводительные вычислительные кластеры, используемые для научных и нженерных расчетов, под задачи области big data, нефтегаз, сейсмика, геофизика, и прочие такие же специализированные штуки.

Основным конкурентом для E5500 в NetApp рассматривают продукты сравнительно малоизвестной в России компании DDN (Data Direct Network), специализированной на перечисленном выше рынке высокопроизводительных, bandwidth-oriented задач, а также столь же “специальный” EMC Isilon.

Отсюда вы уже поняли, как я надеюсь, что это не general purpose сторадж, которыми в линейке NetApp остаются FAS, но если вы работает с вычислительными кластерами, GPFS и Lustre, с big data, с DSS-аналитикой, со всяческими специализированными, скорее научно-инженерными решениями типа геофизики – вот тогда это для вас.

Как вы помните, в прошлом году NetApp активно развивала модели E-series, добавляя в них более привычные для пользователей FASфичи, такие как снэпшоты, thin provisioning, репликацию, и прочее. Всего этого пока, на момент выпуска в марте на E5500 нет, официальный выпуск версии SANtricity для этой модели, с поддержкой всех этих фич, уже доступных для E2600 и E5400, намечен на конец этого года, вероятно еще нужно время на отладку. Однако уже сейчас можно начать использовать с E-series обкатанный на семействе FAS сервис Autosupport.

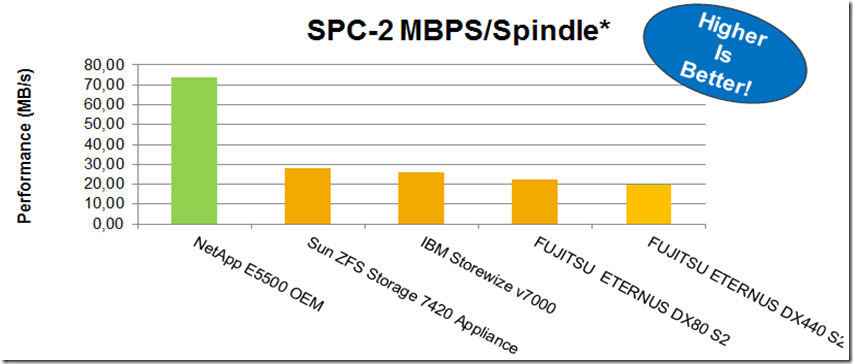

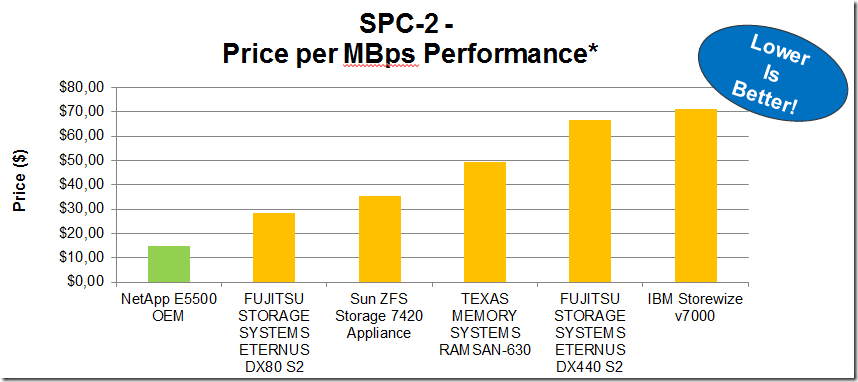

Не могу также не отметить крайне меня радующий факт, что NetApp, представляя новую модель, очень часто демонстрирует не только маркетинговый булшит общие слова о “крутизне” нового “решения”, но подтверждает их открытыми тестами. В данном случае NetApp опубликовал тест для SGI InfiniteStorage 5600 – это та самая наша E5500, просто продаваемая SGI как OEM-партнером, и ее результаты можно рассматривать как vanilla-E5500. Опубликованы результаты SPC-2. Почему не SPC-1, спросите, возможно, вы? Дело в том, что SPC-2 это high-bandwidth бенчмарк, объемные, но преимущественно последовательные чтения-записи, в то время, как SPC-1 это IOPS-oriented, то есть random чтения-записи. таким образом для general purpose задач, для баз данных OLTP, и прочего, более показательны результаты SPC-1, а для big data, DSS-баз, и прочего, перечисленого выше как рынок E-класса – более показателен SPC-2.

?? результаты там говорят сами за себя:

Тут конечно нет главных игроков, уже упомянутых DDN и Isilon, которые предпочитают не подтверждать маркетинговые заявления открытыми бенчмарками, но и сравнение с уже опубликованными игроками также весьма показательно, в особенности для понимания, почему general-purpose массивы так посредственны и непропорционально дороги на специализированных применениях Big Data и High-bandwidth.

??з интерфейсов подключения поддерживается, как и в случае EF540, такие варианты, как восемь SAS 6Gbit/s, или же шесть Infiniband 40Gbit/s. Для конфигураций, куда нацелен E5500 это все крайне востребовано. С контроллерами E5500 будут также предлагаться несколько различных типов полок расширения, что позволяет стрить различные конфигурации, например много контроллеров для высокопроизводительного ввода-вывода, или же наоборот, много дисков (например уже знакомые вам 60 дисков NL-SAS в 4U полочные конструктивы) для сверхъемких систем. Поддерживаются и SSD для кэширования, как это уже опробовано на E5400.

Отмечу, что многим будет любопытно узнать, что кодовое название проекта E5500 в NetApp было – Soyuz, в честь знаменитой советской, ныне российской ракеты.