Производительность на NFS: эксперимент

Уже цитировавшийся в этом блоге специалист по Oracle и блоггер NetApp с ником Neto (ранее из Бразилии, а теперь сотрудник датацентра NetApp в Triangle Park, USA), опубликовал результаты интересного эксперимента, демонстрирующие возможности и производительность NFS на системах хранения NetApp. Ниже перевод его заметки.

Не могу поверить… Еще остались люди, которые не верят в производительность на NFS

Posted by neto on Oct 8, 2011 5:23:41 AM

Многие годы я получаю много вопросов и FUD на тему того, что, якобы, NFS не обеспечивает достаточно хорошую производительность.

Давайте смотреть.

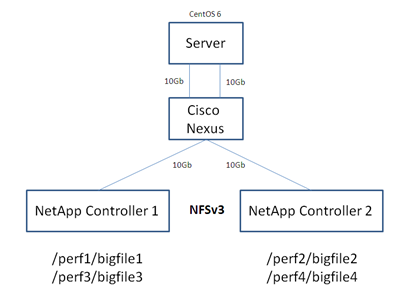

Linux CentOS 6 с двумя портами 10Gb Ethernet (Jumbo Frames ON)

NFS v3

NetApp Cluster – каждый с одним интерфейсом 10Gb Ethernet (Jumbo Frames ON)

Cisco Nexus Switch

Я создал 4 файла на каждой mountpoint:

Запускаем ORION…

http://www.oracle.com/technetwork/topics/index-089595.html

ORION (Oracle I/O Calibration Tool) это инструмент для тестирования и калибровки показателей производительность ввода-вывода системы хранения, намеченной для использования под базы Oracle. Результаты полезны для понимания возможностей системы хранения по производительности, а таже для поиска проблем, которые могут отражаться на производительности базы Oracle, или же для сайзинга нвой инсталляции. Так как ORION это отдельный инструмент, то для проведения измерений пользователям не требуется создавать и запускать базу Oracle.

ORION генерирует синтетичекую нагрузку ввода-вывода максмально приближенную к работе базы данных Oracle, и использует тот же I/O software stack, что и Oracle. ORION может быть сконфигурирован на генерирование широкого диапазона нагрузки ввода-вывода, включая нагрузки характерные для OLTP и data warehouse.

./orion_linux_x86-64 -run advanced -testname disk1 -num_disks 64 -matrix point -num_small 0 -num_large 1 -size_large 1024 -type seq -num_streamIO 8 -write 0 -simulate raid0 -cache_size 0 -duration 60 &

./orion_linux_x86-64 -run advanced -testname disk2 -num_disks 64 -matrix point -num_small 0 -num_large 1 -size_large 1024 -type seq -num_streamIO 8 -write 0 -simulate raid0 -cache_size 0 -duration 60 &

./orion_linux_x86-64 -run advanced -testname disk3 -num_disks 64 -matrix point -num_small 0 -num_large 1 -size_large 1024 -type seq -num_streamIO 8 -write 0 -simulate raid0 -cache_size 0 -duration 60 &

./orion_linux_x86-64 -run advanced -testname disk4 -num_disks 64 -matrix point -num_small 0 -num_large 1 -size_large 1024 -type seq -num_streamIO 8 -write 0 -simulate raid0 -cache_size 0 -duration 60 &

Копируем скриншоты…

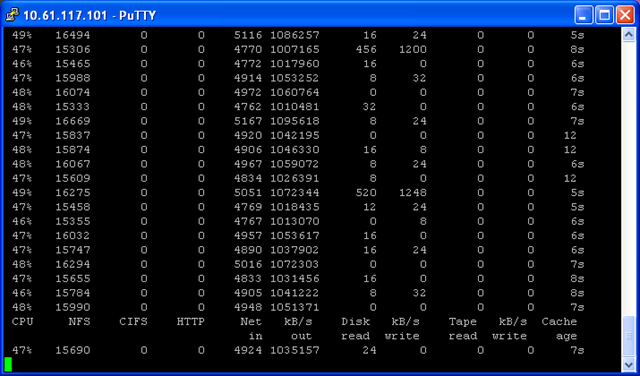

Controller 1

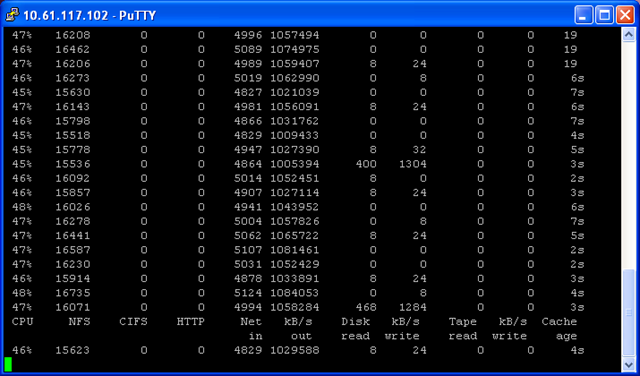

Controller 2

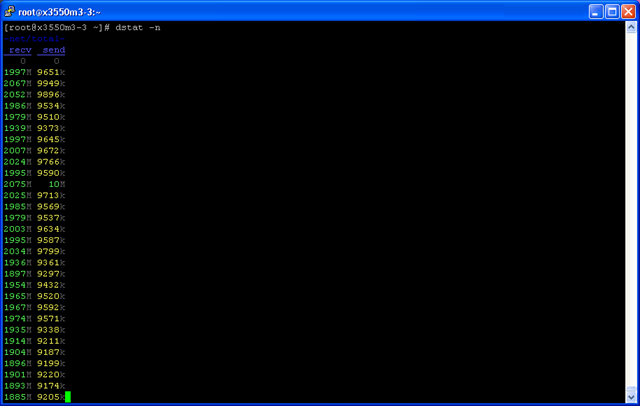

Server

Я полагаю, что 2 гигабайта (БАЙТА!) в секунду, этого должно хватить! Так-то. :-)

NFS это хорошо (на NetApp, конечно же).

Всех благ!

Neto

Как известно overhead of NFS до 80% off overall operation medatata.

Следовательно проверка будет коректна когда мы работаем с реалистичным количеством файлов .

Стоит проверить открытие tar file через NAS and SAN .

В работе с большим количеством файлов NFS медленей в разы чем SAN .

motl:

То есть вы, как в анекдоте про сибирских мужиков, которые тестировали новую японскую бензопилу, считаете, что обязательно надо найти ту редкую задачу, с которой NFS не справится, и именно на ней его тестировать, пусть бы она и не была применима к реальному использованию, да? ;)

Не думаю, что “открытие tar”, как и “работа с большим количеством файлов” есть показательные и применимые области для сегодняшнего использования NFS в базах данных Oracle или для хранения датасторов VMware.

Но, безусловно, если ваша работа заключается в постоянном открытии tar-ов, то вам следует поискать другое решение ;)

Мне кажется что все фирмы использующие eda tools то есть весь semiconductor (Freescale ,TI,Marvell,etc…).

??менно работают с большим колочеством файлов, иногда с милионами в одном volume .

?? тут известна слабость NFS и не только на NetApp.

Пытаются бороться с этой слабостью с помощью PAM и разных оптимизаций но далеко не всегда успешно , сказывается ушербность протокола .

Metadata просто душит NetApp .

Посмотрите в NetApp Manegment Console (DFM насадка) OPS by OPtype NFS3 и увидите что 80% идет на metadata.

Что до tar файлов то это просто пример для проверки где NFS real flop .

Overall NetApp достаточно ультимативный NAS но имеет болезни свойственные NFS .

?? проверка с двумй файлами просто не интиресна .

motl:

Э-э-э. Еще раз. Видимо был неправильно понят.:)

Оттого, что NFS плохо работает в каком-то одном случае его использования, не следует, что он плохо работает во всех случаях.

Просто не нужно пытаться пилить рельсу бензопилой. :)

То что она ее плохо пилит - это не проблема бензопилы.

Если вам не интересно как работает NFS “с двумя файлами” не значит, что это не интересно database admins, которые юзают Oracle 11 over dNFS, и которые именно так его и используют.

Это имено то что я говорю .

Нет уневерсальной бензопилы . :)

The dNFS только для Oracle правильно ?

Кстати имеите опыт работы с NFSv4 on NetApp ?

motl:

dNFS - для Oracle, kernel NFS для других баз, например для mySQL.

NFS сейчас также очень широко применяется для подключения датасторов VMware и Xen.

NFS это уже давно не только “протокол подключения хоумдиров для юзеров на UNIX-машинах”, область его применения куда шире.

Безусловно , NFS имеет очень широкое приминение в NetApp storage .

Я понимаю почему работа с data store of VMware over NFS не хуже чем через SAN .

Там одиночные файлы и NFS с ними хорошо справляется .

Я далеко не фанат SAN но как мы согласились выше, нет уневерсальной бензопилы .

?? снова весь semiconductor mostly Unix based отсюда NFS узкое место очень часто.

Вопрос можно ли получить advantage от перехода на NFSv4 ?!

motl:

Я плохо помню, увы, что из возможностей NFSv4 реализовано и применимо в NetApp.

Точно пока нет v4.1, то есть ‘pNFS’, он появится(лся) в G8 Cluster Mode.

Что же касается применимости в предприятиях semiconductor design, то в success stories есть упоминание о успешном использовании NetApp в таких компаниях, как Xilinx (45 систем хранения как NAS, так и SAN), CSR (Cambridge Silicon Radio) системы многоузлового кластера NetApp GX, к сожалению, подробностей не очень много, но как зацепку можете использовать, чтобы найти какие-то детали.

Спасибо .

Сайт просто отличный .

Но хотелось бы больше оригинальных статей с техническими деталями (О том какие имплементации есть в России).

Кстати насколько распостронён NetApp России ?

Is it mainstream in NAS ?

motl:

Ответ получится довольно длинный.

Хотя NetApp и был одной из тех компаний, которые начали прицельно и активно заниматься именно NAS (другие - Auspex, Sun и, отчасти, 3Сom, уже не существуют на рынке, по разным причинам), тем не менее сегодня крупнейшую рыночную долю держит все же EMC, NetApp второй.

Однако специфика России (возможно когда-нибудь я об этом напишу статью) в том, что здесь исторически не было рынка для NAS, а российский IT “ультра-право консервативен” выражаясь языком политики.

По этой причине под словом NAS в России массово понимается “китайский платиковый бокс на два диска, под линуксом с самбой, умеющий качать торренты” и “ведущие вендоры рынка NAS” не EMC и NetApp, а Nеtgeаr и Synоlоgy. :)

Досаточно посмотреть насколько отличаются объемом и качеством статья “NAS” на русскоязычной и англоязычной Википедии, чтобы понять масштаб пропасти в области NAS у России и остального мира.

Относительно success stories на российском рынке.

Не секрет, надеюсь, ни для кого, что success stories это товар, который вендор покупает, тем или иным путем, у соответствующей компании.

К сожалению, маретинговый бюджет российского NetApp не позволяет заинтересовать клиентов публиковать свои Success Stories, именно этим объясняется то, что, несмотря на очень успешные продажи в России в самых разных областях, как таковые истории внедрений и технические их детали почти не встречаются в прессе.

Обычно некоторые Success Stories NetApp обнародует на ежегодной конференции NetApp Innovation. Но, в общем, публикуемое это капля в море.

Публикации о зарубежных инсталляциях встречаются чаще, но и там, увы, совсем на глубокотехнический уровень не лезут. Отчасти потому, что success stories это все же документ воздействия на уровень топов и CIO, которым малоинтересны уж совсем “иопсы”, а не deployment guide для сисадминов, отчасти оттого, что некоторые вещи могут считаться компаниями конфиденциальными.

Спасибо за детальный ответ .

Очень интиресно о представлении NAS в Росси.

Сам не живу в Росси под 2 десятка лет и было очень интиресно прочитать ваш коментарий .

В фирме где я работаю несколко кластеров 6240 и в силу того что все в основном UNIX , ищу способы оптимизации NFS .

Конечно мы получаем помощь от локального NetApp .

Но HPC растет очень быстро и требует соответствия от storage .

В силу того что cluster mode ещё очень сырой приходится искать оптимальные вещи в 7 mode .

Думали даже проверить GPFS solution но побоялись из за слабой представлености на нашем рынке .

Вобщем scale out не хватает NetApp.

Надеюсь нормальный cluster mode не за горами.

motl:

Я бы в вашей ситуаци все же еще раз посмотрел на 8.0 Cluster-mode.

Оно довольно активно развивается, и, судя по всему, в ближайшеее время станет мэйнстримом, по крайней мере для самого NetApp и его разработчиков, все силы будут брошены на него.

В 8.1RC2, о котором объявят на днях уже сделали и SnapMirror, и дедупликацию, и SAN-протоколы. А цену на двухнодовую Cluster-mode обещали как на HA-cluster 7-Mode, и вообще собираются продвигать его куда активнее, чем раньше.

Так что оно растет, и довольно шустро, и ситуация с ним меняется довольно быстро. Посмотрите, может быть уже вам подходит.

С кэшированием метаданных должен очень хорошо справляться Flash Cache, и может быть даже и PAM (тот, что с DRAM). Эффективность можно посмотреть на результатах SPECsfs2008, который, как тест, очень и очень нагружен работой с метаданными. Если у вас нет Flash Cache или PAM, то я бы для 7-Mode и NFS в первую очередь на них бы посмотрел.

Начну с конца.

Мы конечно же используем PAM иначе бы давно задохнулись.

Кстати я думал что PAM и Flash Cache это тоже самое .

Будьте добры объясните разницу .

К сожалению именно из за отсутствия snapmirror 8.0 Cluster-mode даже не расматривался. (RS2 will change the situation if so ).

Теперь будем ждать GA.

Послушаем что скажут на конференции в Риме в конце этого месяца .( Our reseller should be there ) .

Надеюсь вы тоже будете там и привезете много интиресных статей .

motl:

Официально PAM (Performance Acceleration Module) это устройство со сравнительно небольшой памятью на DRAM, “первое поколение”. Позже появился аналогичный модуль, но с использованием гораздо большего объема (256GB/512GB/1TB) на Flash. Некоторое время он назывался PAM-II, позже был переименован для ясности в Flash Cache.

8.1 Cluster-mode правда “подрос”, вот буквально на днях NetApp выкатил целую серию результатов в SPEC sfs2008 NFS на нем, на разном количестве нод. Может быть интересно, посмотрите. Там такой же как у вас 6240.

??нтересно, что результаты показывают практически линейную масштабируемость производительности от 4 до 24 нод.

В Риме не буду, к сожалению, я на другом конце мира, так сказать в APAC ;), но буду следить, безусловно, и контачить с человеком, который поедет.

Понял, историю я в принципе знал (worked with PAMI and 3160 ) но маркетенговые названия запутали, спасибо за объяснение.

Надеюсь что для миграции на Cluster-mode не нужно будет переходить как с trad to flex or aggr 32bit to 64bit.

Кстати насколько понял переход to 8.1 aggr 64bit можно будет делать VSM а не QSM как мы сдалали (~1000 qtree) :)

Я нахожусь на middle east и здесь более чем распространен NetApp.

На следуюшей неделе начинаем большой план по миграции VMware to NetApp.

> Я нахожусь на middle east и здесь более чем распространен NetApp.

Да, я вижу Безек по IP :) Ну в ??зраиле традиционно весьма большое лобби у NetApp, это известный факт.

> Надеюсь что для миграции на Cluster-mode не нужно будет переходить как с trad to flex or aggr 32bit to 64bit.

Disruptive, к сожалению, связанный с полной сменой структуры данных на дисках от 7-mode к Cluster-mode. :(

GX имеет возможность data-in-place upgrade на 8.0/8.1 Cluster-mode.

> Кстати насколько понял переход to 8.1 aggr 64bit можно будет делать VSM а не QSM как мы сдалали (~1000 qtree) :)

Сейчас на 8.1 реализована data-in-place конверсия из 32-bit в 64-bit. Просто при росте размеров aggregate выше 16TB он автоматически преобразуется в 64-bit.

Это не лоби это fan club :))

Я познакомился с NetApp в 1998 когда фирма в которой работал первая начала продавать его в ??зраиле .

Так что NetApp прописался тут давно и надолго .

Меня очень интересуют темы performance and deep analises .

Такие вещи как глубокое понимание: stats, statit , etc..

Вы планируете написать на эту тему не для новичков ?

Было бы очень интиресно .

Так как нет курсов на эту тему для клиентов .