??так, завершая наш цикл постов про переход с Data ONTAP 7-mode на Clustered Data ONTAP, принципиально новую версию OS Data ONTAP, переход на которую пользователей идет вот уже несколько лет, и вот, наконец, этой осенью выходит на финишную прямую, и компания NetApp, наконец, этой осенью выпускает очередную версию Data ONTAP, в которой уже не будет режима 7-mode, и будет только Clustered Data ONTAP.

Да, уже существующие системы и версии Data ONTAP продолжат поддерживаться, но все новые версии будут уже только Clustered, или C-mode (Cluster-mode).

Это значит, что именно этой осенью вам стоит решить, остаетесь ли вы на текущей версии, и отказываетесь от всех новых фич, которые уже появились, и еще появятся, или же идете вместе с NetApp.

Одной из основных проблем, среди нескольких, которые встают перед решившимся на такой переход, является невозможность перехода такого, который называется data-in-place, то есть с сохранением данных на дисках на их местах. Невозможность простой миграции - довольно привычная ситуация для пользователей систем других вендоров, стоит вспомнить, например, переход с EMC Clariion на EMC VNX, или с HP EVA на HP 3Par. Все такие переходы у большинства вендоров делается с “полной пересборкой” системы. Нельзя взять дисковую полку от EMC Celerra, со всеми лежащими на них данными, и подключить прямо к VNX, и сразу же продолжать с ними работу.

Не так было у NetApp. Много лет как апгрейд у NetApp делался с полным сохранением данных на диске. Вы могли взять FAS3040 с дисками FC в полках DS14MK4, системы, выпущенной лет 10 назад, и просто заменить ее контроллеры, или же установить на нее самую последнюю версию Data ONTAP и все заработает без необходимости делать бэкап данных, и восстанавливать их на новую систему, на новые, или те же самые диски.

К сожалению, для перехода с 7-mode на Clustered Data ONTAP такого простого перехода сделать нельзя. Структуры данных на дисках существенно и сильно поменялись, поэтому просто “сконвертировать” данные “на месте” - невозможно.

Незадолго до начала задуманной серии постов я встречался со специалистами дистрибуторской компании Netwell, компании, с сотрудниками которой меня связывает долгое сотрудничество по “переводному проекту”. Тогда же они мне рассказали, что они оказывают помощь российским пользователям NetApp по переходу на Clustered Data ONTAP, и миграции данных, предоставляя необходимое оборудование и помогая инженерами, то есть осуществляя Professional Service, как это называется “там”.

?? тогда мы договорились, что знакомый многим по нашему форуму Евгений Денисов, сотрудник Netwell, подробно расскажет про эту услугу в моем блоге.

Ниже - наш разговор.

romx: ??так, что же надо сделать, если мы “решились на переезд”?

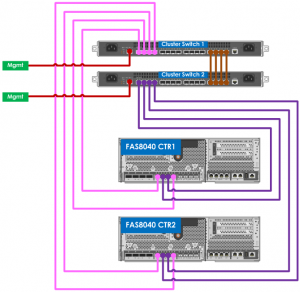

ED: Вам нужно связаться с вашим партнером, через которого вы покупали систему, и, если вы покупали ее через нас, дистрибутора Netwell, то партнер связывается с нами и передает эту задачу нам. Мы контактируем с вами, узнаем, что за конфигурация у вас сейчас, каков объем мигрируемых данных, и прочие технические детали, согласуем сроки. Затем мы привозим к вам на сайт сторадж, собираем его в кластер, затем мигрируем ваши данные на него, затем разбираем и переконфигурируем ваш сторадж в кластер, затем мигрируем данные назад, очищаем наши диски от ваших данных, проверяем, что миграция успешна, и вы получаете готовую систему в Cluster-mode, и с вашими данными, перенесенными на нее.

romx: Этот сторадж, что это?

ED: Это “подменная” система из нашего демо-пула оборудования, которую мы держим для внутренних нужд, демонстраций у пользователей, и так далее. У нас есть также достаточный объем дисков. Впрочем, для очень больших объемов переноса могут быть сложности, так что - связывайтесь предварительно.

romx: Как все это осуществляется физически? Каким образом переносятся данные?

ED: Если это файловые шары, то есть данные хранятся в NAS-режиме, по протоколам SMB/CIFS или NFS, то есть нетапповский инструмент: 7-Mode Transition Tool, 7MTT. Он в полуавтоматическом режиме переносит все данные с системы в 7-Mode на Clustered Data ONTAP. К сожалению такого средства нет для блочных данных, поэтому их мы мигрируем вручную, копированием через хост. На новой системе создается LUN, затем данные со старого LUN-а копируются в новый, затем, после пересборки пользовательской системы в кластер - назад.

romx: Сколько все это занимает времени?

ED: Мы укладывались в довольно большом проекте за выходные. Так что можно считать, что за два выходных дня и менее можно перенести практически любую систему. Бывают всякие случаи, поэтому нам и нужно заранее согласовать объемы работы и время.

romx: Со временем - понятно. А сколько это стоит?

ED: Для пользователей это бесплатно. Ну, то есть это, как любой professional service, стоит денег, но NetApp покрывает эти затраты нам, так как заинтересован в скорейшем и максимально массовом, беспроблемном переходе. Так что для пользователя это бесплатный сервис и бесплатный процесс.

romx: Это сейчас делаете только вы, из всех дистрибуторов в России?

ED: Насколько я знаю - да. Если вы - наши, то вам повезло. Если вы, допустим, “мерлионовские”, то спрашивайте о такой услуге у них. У них также есть необходимые ресурсы это сделать для вас.

romx: Технический вопрос: Получается, что на дисках системы, которую вы привозите для проведения миграции, после нее остается копия пользовательских данных?

ED: Нет, конечно мы уважаем секьюрность пользовательских данных, после миграции все данные на наших дисках уничтожаются в присутствии клиентов. Это может быть или простое удаление всех томов и LUN-ов после обратной миграции (это уже необратимый процесс), либо, если действуют особые требования по информационной безопасности, то делается процесс disk sanitization, это полное затирание содержимого дисков. Это, впрочем, существенно дольше, чем простое удаление.

romx: ?? у вас уже есть опыт такой миграции, да и вообще быстрой сборки и развертывания кластера? Спрашиваю, потому что для любого сисадмина сломать работающую систему - поступок, причем в нашем случае - необратимый. Вдруг что-то пойдет не так? Не удастся все быстро собрать и мигрировать за “maintenance окно”?

ED: Да, конечно, нам уже много раз приходилось собирать у пользователей кластер, это отработанная и накатанная процедура, которую мы уже не раз проделывали. Конечно же это проще и спокойнее сделать пользуясь нашим опытом. Миграцию мы уже также не раз проделывали.

romx: Спасибо, в целом на все вопросы есть ответы. Если у читателей будут еще какие-то уточнения и конкретные вопросы, то их можно задавать?

ED: Конечно, например в комментарии к посту, я их, да и вообще тебя читаю регулярно.