Heartbleed - как обстоят дела с уязвимостью у NetApp?

Те, кто читает новости в интернете про информационную безопасность, те уже знают о том, что на неделе отрасль столкнулась с одной из серьезнейших угроз безопасности доступа к данным, программный баг опенсорсной библиотеки OpenSSL для организации защищенного канала связи, который уже прозвали Heartbleed.

Баг этот, проникший в код библиотеки по недосмотру программиста и проверявшего за ним код, находился там около 2 лет, и его использование позволяет, как выяснилось недавно, с помощью специально сформированного запроса к системе, работающей по протоколу HTTPS, с использованием для его организации той самой библиотеки OpenSSL версии 1.0.1f, получать с этой системы блоки данных из ее памяти (памяти процесса), размером до 64 килобайт.

Проблема состоит в том, что при работе в памяти процесcа, доступной таким образом, могут при этом находиться данные, которые эта система обрабатывала, например логины и пароли, приватные ключи шифрования, прочая конфиденциальная информация, например на платежных шлюзах это будут данные введенных туда другими пользователями карточек, и так далее.

Понятное описание ситуации от XKCD: http://xkcd.com/1354/

Проблема усугубляется еще и тем, что опенсорсные решения в интернете распространены очень широко, и OpenSSL, фактически, единственная библиотека для организации на них работы по HTTPS. По оценке экспертов, до двух третей HTTPS-серверов могут быть подвержены этой уязвимости. Хуже всего то, что баг сидит в текущей версии библиотеки уже очень давно, не был обнаружен оперативно, и почти все актуальные существующие дистрибутивы (например Linux) уже используют именно уязвимую версию библиотеки.

Однако, стоит сказать, что не подверженными уязвимости остались системы, не использующие OpenSSL, их не так много, но они есть, прежде всего это IIS и вообще Microsoft, а также, думаю, всякие старые Solaris, коммерческие Юниксы, и так далее, которые реализовали работу с SSL своими средствами.

Как же обстоят дела в продуктах NetApp, которые, как вы знаете, довольно широко используют оперсорсные компоненты в своих продуктах?

Буквально сегодня NetApp выпустил по этому поводу отчет о уязвимых и безопасных продуктах компании. Полностью его можно посмотреть тут: https://library.netapp.com/ecm/ecm_get_file/ECMP1516404

А вкратце:

Подтверждено отсутствие проблем с Heartbleed у:

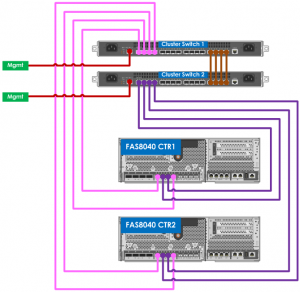

Data ONTAP® (all versions)

Data ONTAP® PowerShell Toolkit

FAS/V-Series Storage Replication Adapter for Data ONTAP® 7-mode

FAS/V-Series Storage Replication Adapter for clustered Data ONTAP®

MetroCluster Plugin for vSphere (MCPV)

NetApp StorageGRID®

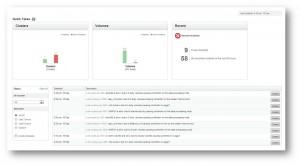

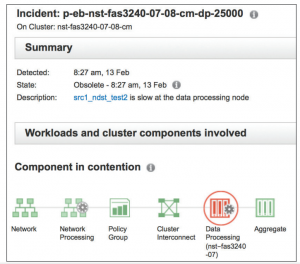

OnCommand® Performance Manager

OnCommand® Plug-in for Microsoft

OnCommand® System Manager

OnCommand® Unified Manager Core Package (6.x)

SANtricity® Storage Manager

SnapCreator® Framework (SCF)

SnapDrive® for UNIX (SDU)

SnapManager® for Oracle (SMO)

SnapManager® for SharePoint (SMSP)

SnapManager for Hyper-V

SnapManager for Oracle (SMO)

Virtual Storage Console (VSC) for Apache CloudStack

Virtual Storage Console for (VSC) Citrix XenServer

Virtual Storage Console VSC) for Redhat

Virtual Storage Console (VSC) for VMware vSphere

vStorage API for Storage Awareness (VASA) 7-mode

vStorage API for Storage Awareness (VASA) cDOT

Подтверждено наличие уязвимости в продуктах:

Clustered Data ONTAP® Antivirus Connector

Data ONTAP® Storage Management Initiative Specification (SMI-S) Agent

E-Series Storage Management Initiative Specification (SMI-S)

NetApp Manageability SDK (5.0P1 and later)

OnCommand® Unified Manager Core Package (5.x)

OnCommand® Workflow Automation (2.2RC1 and later)

Продолжается исследование возможной уязвимости в продуктах:

Open Systems SnapVault®

Recovery Manager for ShareFile

Replication Director

Single Mailbox Recovery

SnapDrive® for Windows

SnapManager® for Exchange

SnapManager® for SQL Server

SnapProtect®