Как вы знаете (должны знать, по крайней мере), NetApp, вот уже третий год пошел, как владеет бизнесом, ранее принадлежавшем компании LSI/Engenio, и производившим системы хранения “классической блочной архитектуры” для различных OEM-клиентов. Таким образом сегодня NetApp это не только традиционные для него стораджи семейства FAS, то есть unified, NAS+SAN, WAFL-based стораджи “со снепшотами и дедупликацией”, о которых в этом блоге в основном и пишется, но также и “традиционные для рынка” блочные стораджи для FC и iSCSI, которые продает как сам, так и поставляет по OEM-контрактам. Так, например, хорошо знакомые российскому IT системы IBM DS3524 и Dell PowerVault MD3 - это как раз они и есть, NetApp E-series.

Некоторое замешательство вызвало в свое время появление такой, необычной для NetApp, линейки продуктов среди пользователей, как же так, мол, а что же FAS, неужели он теперь не хорош, и вы теперь от него отказываетесь и начинаете заниматься продуктом, всю дорогу с ними конкурирующим?

На самом деле те, кто с NetApp уже давно, они знают, что он, как компания, всегда действует в русле здорового прагматизма, без всякого “идеологического паладинства”, если есть направление, в котором можно заработать деньги - действует простое правило: пойди, дай то, что пользователь хочет, и возьми у пользователя за это его деньги, без всяких “фу, это же не настоящий Fibrechannel!” :). Так, в свое время, NetApp вдруг, неожиданно для всех, перестал заниматься только лишь NAS, и быстро сделал поддержку блочных протоколов SAN в своих системах хранения (оставаясь, впрочем, сторонником своей линии, что NAS есть более интеллектуальный и прогрессивный продукт, сегодня мы все видим, что так оно, во многом, и получилось, смотрите как развивается NAS-направление в виртуализации!).

Точно также получилось и с E-series. На рынке существует ниша, в которой многочисленные интеллектуальные преимущества FAS и Data ONTAP не слишком нужны, а нужна там высокая удельная емкость хранения, высокая линейная скорость записи-чтения, возможность DAS-подключения к серверам, поддержка только блочных протоколов, и так далее. Это, например, системы хранения потокового HD-видео от камер видеонаблюдения, это системы для обработки BigData, например под Apache Hadoop, и ряд других таких же нишевых, но очень деньгоемких систем и областей использования. Ну, вот, отчего не расширить туда присутствие на рынке?

Сперва стораджи E-series продавались только в OEM, потом понемногу NetApp начал производить их и продавать от своего имени, сперва в Америке, а теперь и “в канал”, в том числе и в России.

?? вот, на днях, в семействе E-series вышло большое обновление.

Во-первых, появилась новая линейка в нижнем сегменте, той, чем был тот самый IBM DS3524, он же NetApp E2600. Теперь ему на смену появился E2700.

В линейке будет выпущено три модели, это E2712, E2724 и E2760. Последние две цифры модели, как вы уже поняли, это число дисков в конструктиве. 2712 и 2724 это уже знакомые 2U на 12 и 24 диска 2,5″, а вот 2760 это новый для модели E2 конструктив, уже встречавшийся в семействе E5, это 4U с треями “магазинного” типа, на 60 дисков 3,5″ в корпусе, для “сверхплотных” применений.

Контроллеры E2700 оснащаются в базе портами SAS 12Gb/s, и поддерживают расширение с помощью Host Interface Cards (HIC) с портами FC 16G, iSCSI 10G, а также дополнительными портами SAS 12G.

Будут поддерживаться разные типы дисков: SAS, NL-SAS, а также SSD (кроме 2712). Впрочем, про SSD дальше еще пойдет речь в связи с обновлением All-Flash системы EF5.

В остальном - это наследник E2600, все, знакомое вам по этой модели, в новой осталось.

Обновился контроллер у E5500.

E5500 - это системы еще большей производительности, чем были E2600. Теперь в нем добавились (ранее недоступные) интерфейсы FC 16Gb и iSCSI 10G (ранее были только SAS 12Gb, FC 8Gb и Infiniband). Также как у E2700 будут доступны три конструктива, на 12 и 24 диска в 2U, и на 60 дисков в 4U.

Поддерживаемые диски - SAS и SSD.

Наконец, обновился All-Flash storage, который теперь носит название EF550.

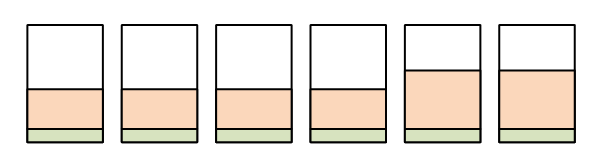

Эта система поставляется в виде 2U корпуса, с вариантами поставки на 12 дисков SSD (9,6TB raw) и на 24 диска SS (19,2TB raw), с общей возможной емкостью системы - 120 дисков.

Поддерживаются интерфейсы:

• 16Gb FC (OM2, OM3, OS1, and OS2 optical)

• 10Gb iSCSI (optical, twinax passive, and RJ-45 Cat 6)

• 6Gb SAS (copper with Mini-SAS cables)

• 40Gb IB (QSFP+ copper and OM3 optical)

Системы поставляются с 800GB SSD дисками технологии SLC, каждый диск оснащен двумя портами ввода-вывода SAS, и имеют пятилетнюю гарантию производителя.

The EF550 ships with 800GB mixed-use multi-level cell (MLC) NAND SSDs from SanDisk with dual (2) full-duplex interface ports. The EF550 actually leverages the dual-active paths from each controller to every SSD as part of its design.

Each SSD is rated at 10 drive writes per day (DWPD), warrantied up to 5 years, but with an endurance lifetime well over 5 years.